人工智慧,或稱 AI,正在發揮強大的影響力 – 用前所未有的速度重塑我們的世界。主動管理是保有競爭力的關鍵,要探索不斷演變的 AI 領域,ASUS 的 AI 基礎架構解決方案不可或缺。ASUS 提供全方位的 AI 解決方案,包括 AI 伺服器和整合式機架、用於大規模運算的 ASUS AI POD,還有最重要的先進軟體平台,可自訂功能處理所有工作負載,提升您在 AI 競賽中的實力以領先群雄。

ASUS 的卓越之處在於整體性的方案和完美協調的尖端硬體與軟體技術,協助客戶加速研究與創新。ASUS 結合卓越的技術與務實的解決方案以開發先進功能,重新定義 AI 驅動產業和日常經驗的更多可能性。

您認為 AI 是面對目前挑戰可能的解決方案嗎?想要運用 AI 開發企業 AI,卻擔心成本以及維護問題嗎?ASUS 提供全方位 AI 基礎架構解決方案,滿足多種工作負載和您所有特定需求。這些針對特定用途的先進 AI 伺服器和軟體解決方案適合處理複雜的任務,例如深度學習、機器學習、預測性 AI、生成式 AI (Gen AI)、大型語言模型 (LLM)、AI 訓練和推理,以及 AI 超級運算。選擇 ASUS 有效處理大型資料集並執行複雜運算。

隨著製造業進入工業 4.0 時代,精密的控制系統需要結合邊緣 AI 以全面提升製程。ASUS 邊緣 AI 伺服器提供裝置即時處理,可改善效率、減少延遲並且強化 IoT 應用的安全性。

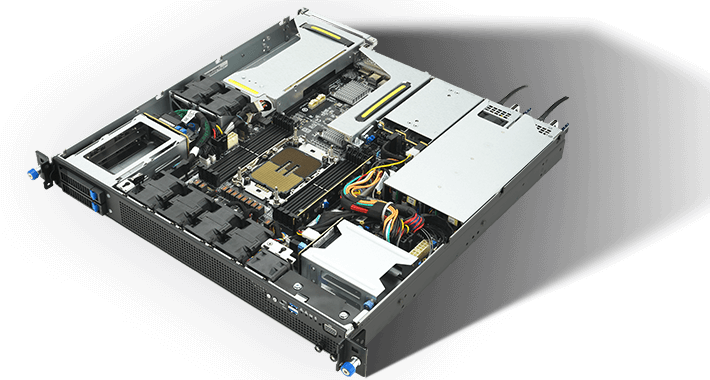

更快的儲存、圖形和網路功能

** 2 個內部 SATA 托架僅適用於 650W/短 PSU 型號

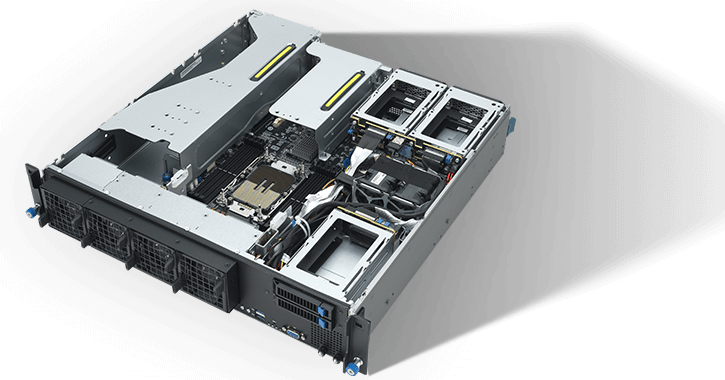

更高的效率、最佳化 GPU 和網路功能

** 無 GPU 的 SKU 適用於 0–55°C 環境,配備 GPU 的 SKU 適用於 0–35°C 環境。

受過嚴密訓練的機器學習模型所面臨的終極挑戰是詮釋全新未見的資料,這項任務涉及大型資料管理和如何克服硬體限制。ASUS AI 伺服器具有強大的資料傳輸功能,藉由訓練後的模型產出準確預測,有效處理即時資料。

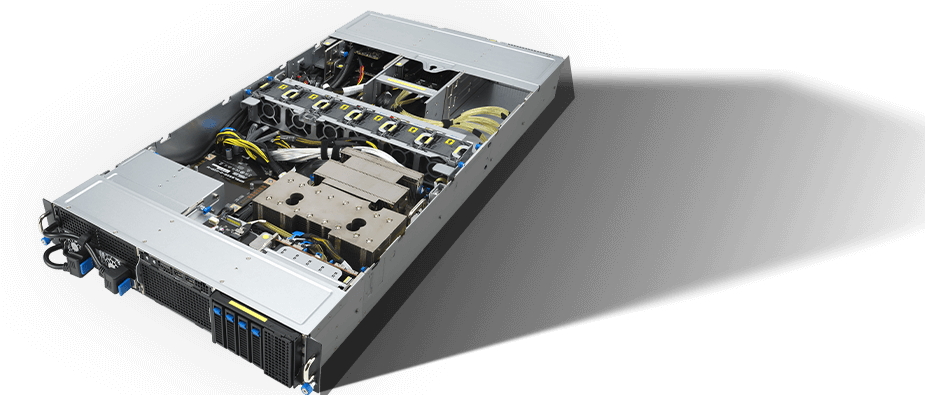

GPU 加速器優化,實現最高效率

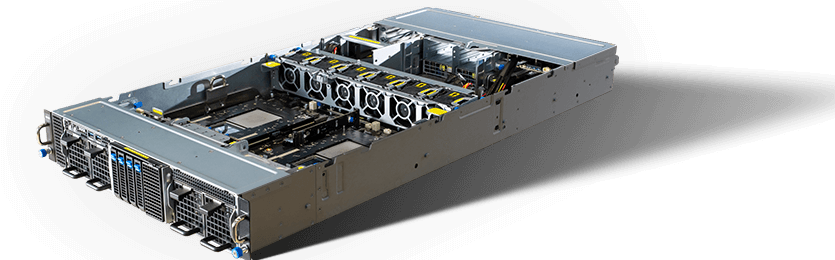

多任務處理效能、效率與可管理性兼具

許多工程師與開發人員透過微調大型語言模型 (LLM),努力增加效能與自訂功能,然而他們經常遭遇部署失敗等種種挑戰。為克服這些問題,極其需要強大的 AI 伺服器解決方案,以確保無縫高效率的模型部署和運作。

2U 高效能伺服器採用 NVIDIA Grace-Hopper Superchip 搭配 NVIDIA NVLink-C2C 技術

適用於生成式 AI 和 HPC 的 2U NVIDIA MGX GB200 NVL2 伺服器

無論您是否進行 AI 研究、資料分析或 AI 應用部署,ASUS AI 伺服器的出色效能和擴充能力受到肯定,能處理複雜的神經網路訓練並大幅加速訓練流程 – 完全釋放 AI 應用的可能性。

發揮極致效能的生成式 AI 與 LLM 工作負載

為生成式 AI 和大型語言模型 (LLM) 工作負載提供渦輪加速

ASUS 8 GPU AI 伺服器在密集 AI 模型訓練、大型資料集管理以及複雜運算方面表現出色。這些伺服器專為 AI、機器學習和高效能運算 (HPC) 而設計,確保頂尖的效能和可靠性。

專屬深度學習訓練和推理

以卓越效能賦能 AI 和 HPC

處理繁重 AI 工作負載的最佳選擇

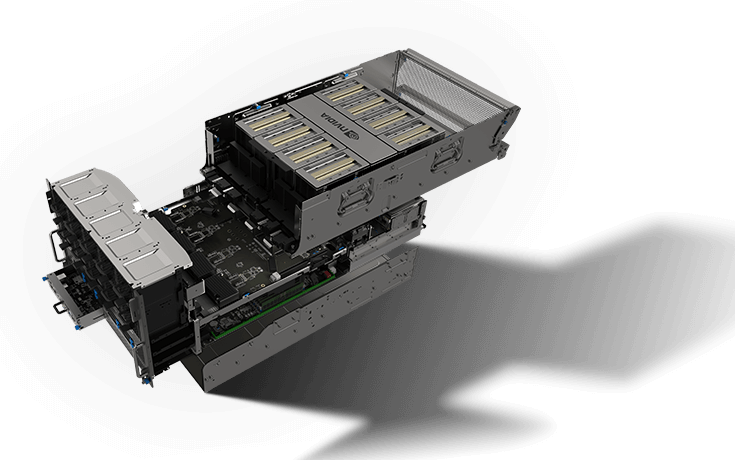

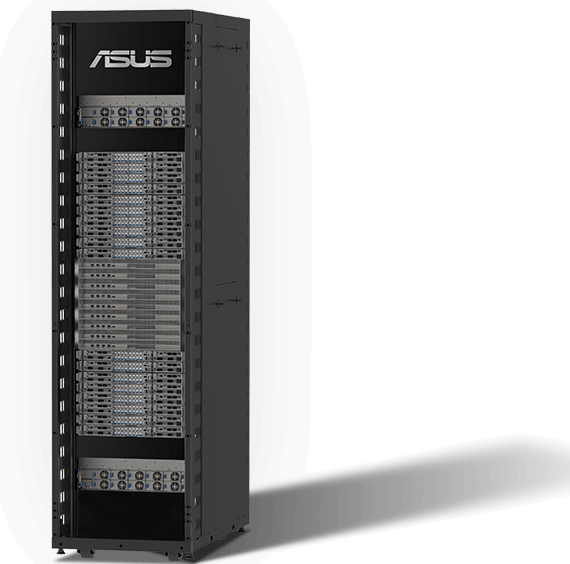

AI 超級電腦由精密調校的硬體打造而成,包含無數的處理器、專門的網路設定和龐大的儲存裝置。ASUS 提供統包式解決方案,以專業全方位處理超級電腦的建置,從資料中心設置、機櫃安裝到徹底測試和上線面面俱到,並以嚴苛的測試保證頂尖的效能。

超越想像的 AI。完全釋放。

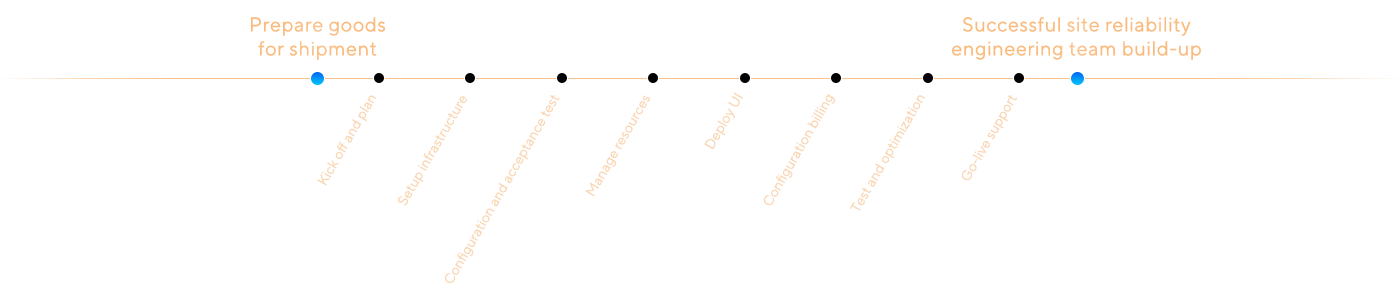

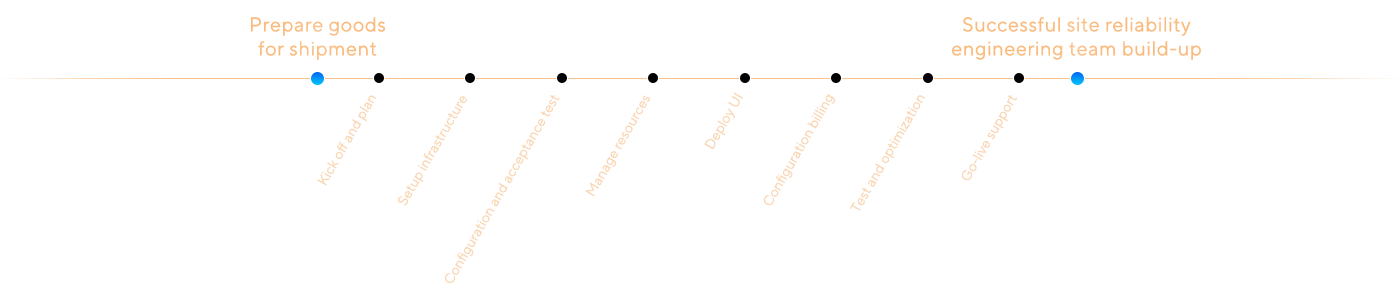

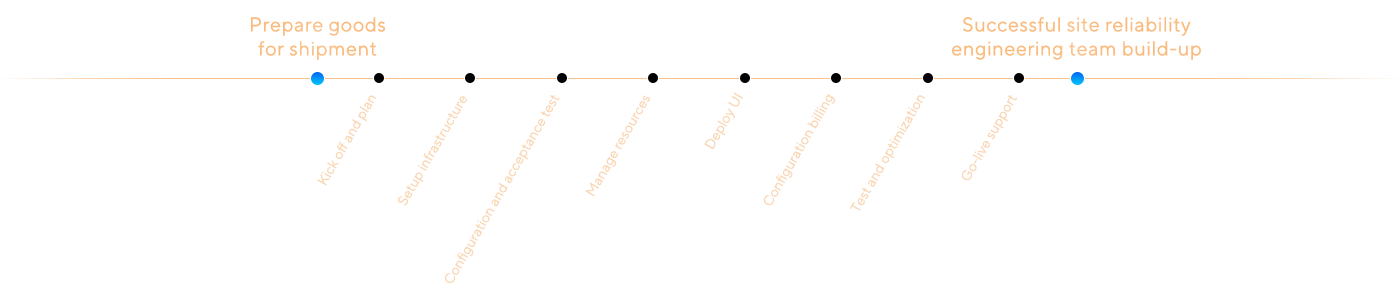

投資了 AI 伺服器卻不知道如何透過使用者友善的 AI 軟體來簡化管理、最佳化效能嗎?ASUS 和 TWSC 整合先進的 AI 軟體工具和 AI Foundry 服務,促進 AI 應用的開發、部署與管理。僅需短短 8 週*,ASUS 團隊便能完成標準的資料中心軟體解決方案,包括叢集部署、計費系統、生成式 AI 工具,以及最新的 OS 驗證,安全性更新、服務修補程式和更多功能。

ASUS 提供關鍵的驗證及驗收服務,包括全方位的軟體堆疊,確保解決方案在實際環境中能完美運作。此階段會驗證解決方案合乎所有特定要求,並確保在每個客戶的特定 IT 設置下進行無縫溝通。此程序由嚴格檢查電源、網路、GPU 卡、電壓和溫度開始,以確保順利啟動和正常功能。交貨前透過詳盡的測試程序識別並解決問題,確保資料中心在全負載狀態之下能可靠運作。

ASUS AI 基礎架構解決方案遵循嚴謹工序提供擴充能力,無縫適應您日漸成長的 AI 需求,確保您維持靈活度和因應未來需求的能力。

*請注意:交付時間可能因客戶自訂要求和專案範圍不同而改變。

選擇 ASUS AI 伺服器以大幅節省時間,相較於手動設置可降低高達 50% 的部署時間 – 並且能實現無縫整合以及效能改善。ASUS 團隊藉由專業知識預防錯誤配置,大幅避免錯誤與降低停機時間,確保您的伺服器運作流暢又可靠。ASUS 透過直觀易用的介面和強大的自動化功能簡化伺服器管理,使您能夠輕鬆處理複雜任務。

ASUS 遙遙領先其他競爭對手,提供先進的運算和 AI 軟體服務,包括高效能運算服務,GPU 虛擬化管理、整合用於管理模型的外部系統、私有雲服務部署、生成式 AI 訓練,以及資料中心整合式軟硬體解決方案。

*可提供的服務可能因不同國家/地區而異。

人工智慧的發展正迅速重新塑造商業應用和消費者的生活方式。ASUS 的專業之處在於完美協調硬體與軟體技術,協助客戶加速研究與創新工作

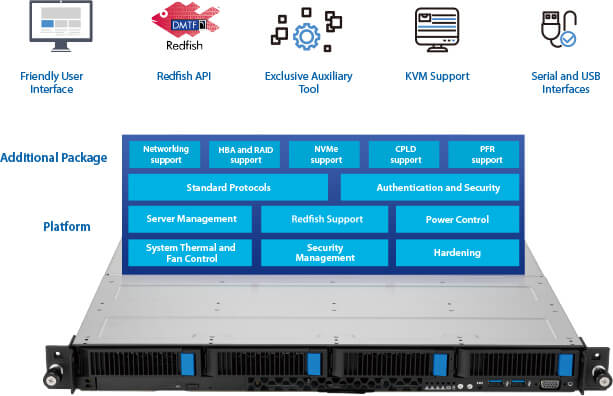

ASUS ASMB11-iKVM 是一款最佳化的韌體管理工具,適用於採用 IPMI 和 Redfish 通訊協定的伺服器和資料中心營運,支援存取和監控所有硬體狀態、感測器和更新,而帶外管理可顯著減少遠端備援 IT 作業和部署。ASMB11-iKVM 更連接 BIOS、BMC、伺服器資訊和關鍵零件,提供多重路由以服務幾乎所有需求 – 提升 IT 營運效率變得快速又輕鬆。

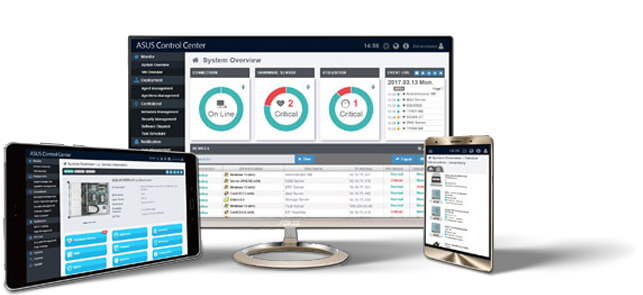

ASUS Control Center (ACC)專為高效率 IT 管理量身打造,包含硬體與軟體庫存管理,以及遠端調派軟體和韌體更新,也可以進行簡單的遠端裝置配置和健康檢查,並快速部署最新安全政策和修補程式。總之,ACC 是用於 IT 管理的一站式入口網站,已經獲得全球各種產業及企業廣泛採用,徹底減少管理時間並大幅提升正常運作時間。

在人工智慧快速演進的環境中,企業需要強大的解決方案,能夠快速部署並在適合企業的服務層級協議 (SLA) 下可靠運作。AFS POD 解決方案專為在生成式 AI 領域中競逐的雲端服務供應商所設計,結合最先進的技術與全方位服務保證以滿足需求。

系統直觀易用的入口網站,可讓開發人員和 IT 管理員輕鬆存取各種生成式 AI 服務和資源。使用者友善的介面可快速部署工作負載並提供即時作業監控,確保產品順利發布。

4 項 ASUS SLA 保證

生成式 AI 雲端服務消弭了軟硬體之間的鴻溝,簡化資源管理並提供廣泛的工具與計費選項。我們的服務透過高度量身打造的功能與程序,滿足不同營運商的多樣需求,引領雲端運算更上一層樓。

透過 ASUS AI 伺服器解決方案發揮 NVIDIA Omniverse™ 所有潛能。ASUS 伺服器專為加速 3D 設計協作與模擬而打造,搭載 NVIDIA AI Accelerator 解決方案,無縫整合 Omniverse,無論內部部署或混合雲解決方案,都能提供無與倫比的效能、可靠性與擴充能力。

ASUS AI 伺服器是 AI 服務的理想平台,確保客戶想部署的任何 AI 應用均能無縫相容與運作。ASUS 也協助服務排程與資源監控,確保在 ASUS 硬體上的流暢運作。

ASUS 瞭解硬體釋放 AI 完整潛能之關鍵作用,我們的平台將微調和推理功能,直接與運算伺服器、網路拓樸結構和高速儲存解決方案進行無縫整合,最佳化系統效能並加速您的 AI 計畫。

我們透過合作整合相關解決方案,包括 WEKA、AIHPC、Asia-Pacific Intelligence 以及 TWSC 等,這些解決方案也整合第三方 AI 應用程式支援全方位的功能。透過我們的平台,您不須犧牲準確度即可體驗更高速的推理、降低延遲時間並減少消耗資源。快速有效的部署尖端 AI 模型,實現您的創新想法,並在競爭中搶先提供市場最先進的解決方案。